VLOGGER是什么

VLOGGER AI是谷歌的研究团队开发的一个多模态扩散模型,专门用于从单一输入图像和音频样本生成逼真的、连贯的人像动态视频。该模型的主要功能在于使用人工智能模型,将一张静态图片转换成一个动态的视频角色,同时保持照片中人物的逼真外观。此外,VLOGGER还能够根据音频来控制人物动作,不仅仅是面部动作和嘴唇同步,还包括头部运动、目光、眨眼以及上身和手部手势,从而将音频驱动的视频合成推向了一个新的高度。

VLOGGER的官网入口

- 官方项目主页:https://enriccorona.github.io/vlogger/

- arXiv研究论文:https://arxiv.org/abs/2403.08764v1

VLOGGER的功能特性

- 图像和音频驱动的视频生成: VLOGGER能够根据单张人物图像和相应的音频输入生成说话人类的视频。用户只需提供一张图片和一段音频,VLOGGER将生成一个视频中的人物,其面部表情、嘴唇动作和身体语言与音频同步。

- 多样性和真实性: VLOGGER生成的视频具有高度的多样性,能够展示原始主体的不同动作和表情,同时保持背景的一致性和视频的真实性。

- 视频编辑: VLOGGER可以用于编辑现有视频,例如改变视频中人物的表情,使其与原始视频的未改变像素保持一致。

- 生成移动和说话的人物: VLOGGER可以从单张输入图像和驱动音频生成说话面部的视频,即使没有视频中人物的原始视频资料。

- 视频翻译: VLOGGER能够将一种语言的视频转换为另一种语言的视频,通过编辑唇部和面部区域以匹配新的音频,实现跨语言的视频内容适配。

VLOGGER的工作原理

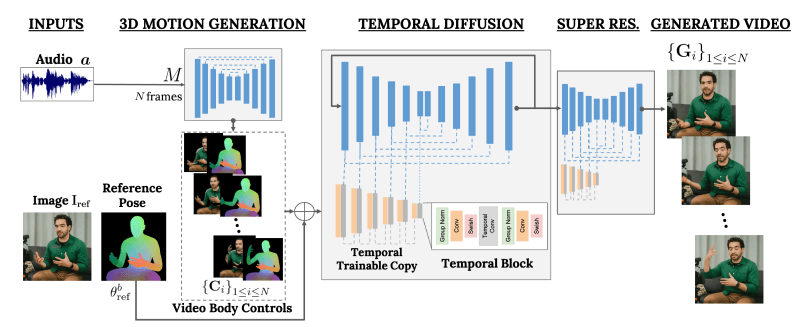

VLOGGER的工作原理主要基于一个两阶段的流程,结合了音频驱动的运动生成和时间连贯的视频生成。

第一阶段:音频驱动的运动生成

- 音频处理:VLOGGER首先接收一段音频输入,这可以是语音或音乐。如果输入是文本,它也会通过文本到语音(TTS)模型转换为音频波形。

- 3D运动预测:接着,系统使用一个基于变换器(Transformer)架构的网络来处理音频输入。这个网络被训练来预测与音频同步的3D面部表情和身体姿势。网络使用多步注意力层来捕捉音频的时间特征,并生成一系列的3D姿势参数。

- 生成控制表示:网络输出的是一系列预测的面部表情(θe i)和身体姿势的残差(∆θb i)。这些参数随后用于生成控制视频生成过程的2D表示。

第二阶段:时间连贯的视频生成

- 视频生成模型:VLOGGER的第二个阶段是一个时间扩散模型,它接收第一阶段生成的3D运动控制和一张参考图像(即输入的单一人物图像)。

- 条件化视频生成:视频生成模型是一个基于扩散的图像到图像翻译模型,它利用预测的2D控制来生成一系列帧,这些帧按照输入的音频和3D运动参数进行动画处理。

- 超分辨率:为了提高视频质量,VLOGGER还包括一个超分辨率扩散模型,它将基础视频的分辨率从128×128提升到更高的分辨率,如256×256或512×512。

- 时间外延:VLOGGER使用时间外延(temporal outpainting)的技术来生成任意长度的视频。它首先生成一定数量的帧,然后基于前一帧的信息迭代地生成新的帧,从而扩展视频的长度。

数据集和训练

- VLOGGER在名为MENTOR的大规模数据集(2200个小时和800000个身份)上进行训练,这是一个包含大量身份和动态手势的大规模数据集。训练过程中,模型学习如何根据3D姿势参数和输入图像生成连贯的、高质量的视频序列。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...