Snap Video是什么

Snap Video是由Snap(社交媒体Snapchat所属的公司)研究团队开发的一个AI视频生成模型,目标是通过文本描述来合成视频,即用户可以输入一段描述性的文本,模型能够根据这段文本生成相应的视频内容。由于视频内容具有高度的冗余性和复杂性,Snap Video旨在解决从文本描述生成高质量、时间上连贯、高运动保真度的视频的挑战。用户研究显示,Snap Video与Pika、Runway Gen-2等视频生成模型相比毫不逊色甚至效果更好。

Snap Video的官网入口

- 官方项目主页:https://snap-research.github.io/snapvideo/

- arXiv研究论文:https://arxiv.org/abs/2402.14797

Snap Video的主要特点

- 视频优先模型:Snap Video是专门为视频内容生成设计的模型,在处理视频的时间连续性和运动方面进行了特别的优化。这与许多其他模型不同,后者通常是从图像生成模型扩展而来,可能在处理视频时存在局限性。

- 扩展的EDM框架:该模型扩展了EDM框架,使其能够更好地处理视频数据的空间和时间冗余,从而提高视频生成的质量。

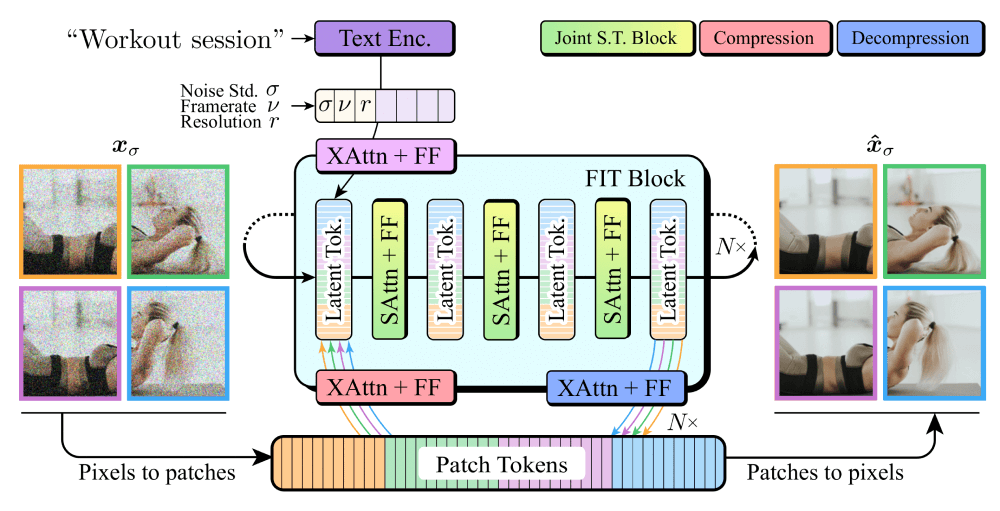

- 高效的Transformer架构:Snap Video采用了基于Transformer的FIT架构,在处理序列数据和捕捉长期依赖关系方面非常有效,尤其是在视频生成任务和处理高分辨率视频中。

- 快速训练和推理:与U-Net等传统架构相比,Snap Video的训练和推理速度更快,能够更高效地生成视频。

- 高分辨率视频生成:Snap Video能够生成高分辨率的视频内容,这在以往的文本到视频生成模型中是一个挑战,因为需要处理更多的细节和复杂的运动。

- 联合空间-时间建模:Snap Video通过联合空间和时间维度的建模,能够生成具有复杂运动和高时间一致性的视频。

Snap Video的技术架构

- 扩展的EDM框架:Snap Video对EDM框架进行了扩展,以适应高分辨率视频的生成。EDM框架原本用于图像生成,通过模拟数据的扩散过程来生成新的数据样本。Snap Video通过引入输入缩放因子(σin),调整了EDM的正向扩散过程,以保持原始分辨率下的信噪比(SNR),从而在高分辨率视频生成中保持了性能。

- 变换器架构:Snap Video采用了基于变换器(Transformer)的架构,这是一种高效的深度学习模型,特别适合处理序列数据。变换器通过自注意力机制(Self-Attention)和跨注意力机制(Cross-Attention)来捕捉输入数据中的全局依赖关系。在Snap Video中,变换器被用来处理视频帧,以生成具有连贯运动的视频。

- FIT架构:Snap Video使用了FIT(Far-reaching Interleaved Transformers)架构,这是一种专门为高分辨率图像和视频合成设计的变换器架构。FIT通过学习输入数据的压缩表示,并在可学习的潜在空间上执行计算,从而允许输入维度的增长而不会显著影响性能。这种压缩表示使得Snap Video能够有效地处理高分辨率视频数据。

- 联合空间-时间建模:Snap Video在生成视频时,同时考虑空间和时间维度,这有助于捕捉视频中的动态变化和运动。这种联合建模策略提高了视频的时间一致性和运动质量。

- 两阶段级联模型:为了生成高分辨率视频,Snap Video采用了两阶段级联模型。第一阶段模型生成低分辨率的视频,第二阶段模型则将这些视频上采样到更高的分辨率。这种级联方法允许模型在保持性能的同时生成高质量的视频。

- 训练和推理过程:Snap Video在训练过程中使用了LAMB优化器,并采用了余弦学习率调度。在推理过程中,模型使用确定性采样器从高斯噪声中生成视频样本,并应用分类器自由引导(Classifier-Free Guidance)来提高文本-视频对齐。

- 条件信息:Snap Video在生成过程中利用了条件信息,如文本描述、噪声水平、帧率和分辨率,这些信息通过额外的读取操作提供给模型,以控制生成过程。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...