DreaMoving是什么

DreaMoving是一个基于扩散模型的人类视频生成框架,由阿里巴巴集团的研究团队开发。DreaMoving通过视频控制网络和内容引导器实现对人物动作和外观的精确控制,使得用户可以通过简单的文本描述或图像提示来生成个性化的视频内容。该框架的目标是生成高质量的定制化人类视频,特别是能够根据给定的目标身份和姿势序列生成目标身份移动或跳舞的视频内容。

DreaMoving的官网入口

- 官方项目主页:https://dreamoving.github.io/dreamoving/

- arXiv研究论文:https://arxiv.org/abs/2312.05107

- GitHub地址:https://github.com/dreamoving/dreamoving-project

- ModelScope魔搭社区:https://www.modelscope.cn/studios/vigen/video_generation/summary

- Hugging Face Demo:https://huggingface.co/spaces/jiayong/Dreamoving

DreaMoving的功能特性

- 定制化视频生成:DreaMoving能够根据用户提供的目标身份和姿势序列,生成相应的人物移动或跳舞的视频,满足个性化视频内容的制作需求。

- 高度可控性:通过视频控制网络(Video ControlNet),DreaMoving可以精确控制视频中人物的动作细节,确保生成的视频具有高度的时间一致性和运动真实性。

- 身份保持:利用内容引导器(Content Guider),框架能够保持视频中人物的身份特征,如面部和服装,确保生成的视频与目标身份高度吻合。

- 多样化的输入方式:用户可以通过文本提示、图像提示或二者结合的方式来指导视频的生成,提供了灵活的创作方式。

- 易于使用和适配:DreaMoving设计简洁,易于操作,并且可以适配多种风格化的扩散模型,以生成风格多样的视频结果。

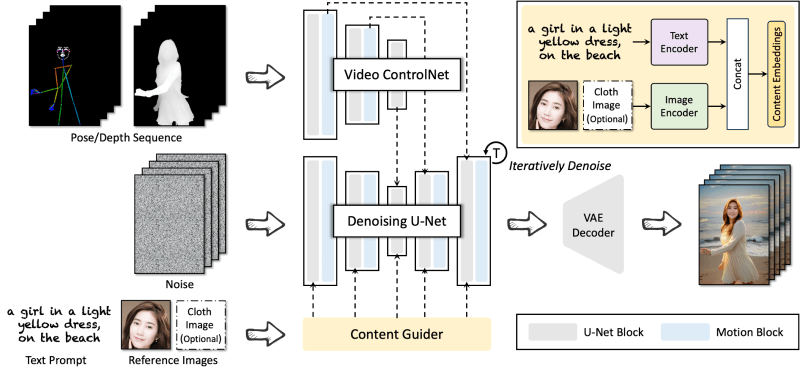

DreaMoving的技术架构

DreaMoving的架构建立在Stable Diffusion模型的基础上,主要由三个核心部分组成,每个部分承担着不同的功能和任务,共同实现高质量的人类视频生成。

- 去噪U-Net:作为DreaMoving的基础网络,负责视频的生成过程。去噪U-Net通过迭代去噪的方式,逐步从噪声中恢复出清晰的视频帧。在每个U-Net块之后,插入了运动块(Motion Block),以增强视频的时间一致性和运动真实性。

- 视频控制网络(Video ControlNet):该网络专门负责控制视频中人物的运动。它作为一个插件模块,与去噪U-Net结合使用,通过处理姿势或深度序列来控制人物的动作。Video ControlNet使得生成的视频能够根据输入的控制序列展现出精确的运动模式。

- 内容引导器(Content Guider):内容引导器的目的是保持视频中人物的身份特征,如面部和服装。它使用图像编码器来精确地引导人物的外观,同时结合文本提示来生成背景内容。内容引导器通过交叉注意力机制,将输入的文本提示和图像特征结合起来,生成具有特定身份特征的视频内容。

这三个网络协同工作,使得DreaMoving能够生成既具有个性化身份特征又具有精确运动控制的高质量人类视频。此外,DreaMoving的架构设计使其易于使用和适配,能够与多种风格化的扩散模型结合,以产生多样化的视频生成结果。

DreaMoving的应用场景

- 电影和电视制作:在影视制作中,DreaMoving可以用来创建复杂的动作场景,特别是当需要特定人物表演或舞蹈动作时。它可以帮助制作团队在预算和时间有限的情况下,快速生成高质量的视频内容。

- 游戏开发:游戏设计师可以利用DreaMoving生成逼真的角色动画,为玩家提供更加丰富和真实的游戏体验。这在角色扮演游戏或动作游戏中尤为重要,可以增强游戏的沉浸感。

- 个性化视频创作:内容创作者可以使用DreaMoving制作个性化视频,例如社交媒体上的舞蹈挑战、模仿秀或其他创意视频。用户可以通过简单的文本或图像输入,快速生成具有个人特色的视频内容。

- 广告和营销:营销人员可以使用DreaMoving制作吸引人的广告视频,通过定制化的人物动作和场景来吸引目标受众,提高广告的传播效果和品牌认知度。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...